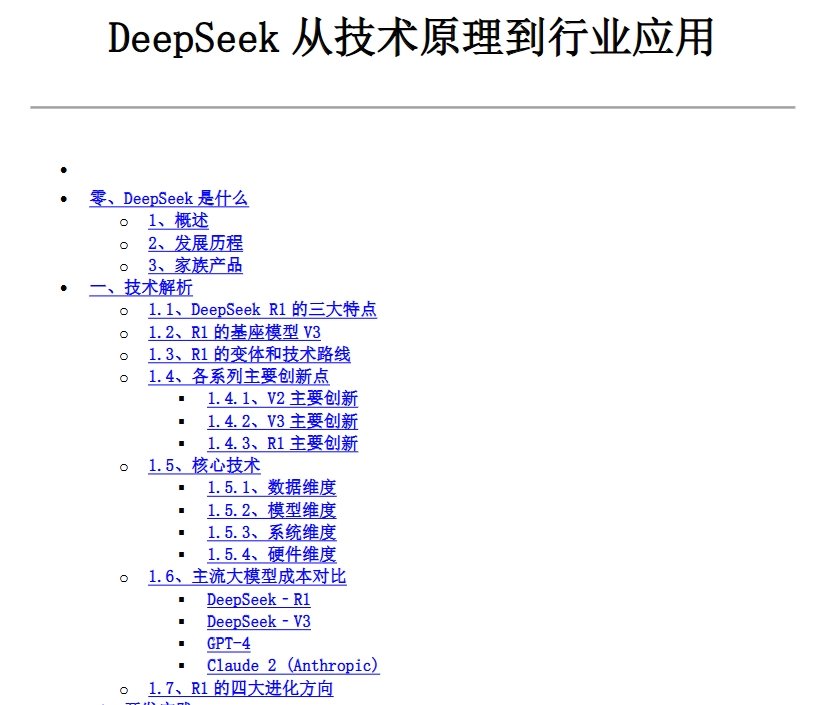

这篇文档系统介绍了国产大模型 DeepSeek 的技术原理、产品矩阵及行业应用,核心内容可归纳为以下四部分:

一、技术突破

文档详细解析了 DeepSeek 的全栈创新路径:在模型架构层面,通过多头潜在注意力(MLA)降低显存占用 93%,混合专家(MoE)架构实现 6710 亿参数规模,多 Token 预测(MTP)提升训练效率;系统层面自研 HAI-LLM 框架,结合 DualPipe 流水线并行和 FP8 混合精度,在 2048 张 H800 集群上实现 85% 算力利用率;硬件层面绕过 CUDA 直接调用 PTX 指令,深度优化降配版 H800 性能。

二、产品矩阵

梳理了 DeepSeek 家族产品线,包括通用对话模型 V3、推理模型 R1、代码模型 Coder、多模态模型 VL2 等,特别强调 R1 通过冷启动数据 + GRPO 强化学习框架,在 6600 亿参数规模下实现推理能力对标 GPT-4,训练成本仅 600 万美元。

三、行业应用

列举了医疗、金融、制造等领域的落地案例:健澜科技基于 R1 的临床决策系统使危重患者风险评估效率提升 42%;江苏银行通过 V2 模型将合同审核效率提升 300%;联想在质检场景实现缺陷识别准确率 99%。

四、生态布局

披露了 DeepSeek 的部署方式(API / 私有化 / 云托管)及接入生态,包括微信、网易有道等头部企业,展示其开源策略(MIT 许可)和低成本路径对行业的普惠价值。

附:下载链接

百度网盘下载地址: https://pan.baidu.com/s/1453zREqQxo3RedoDhUmv7g?pwd=d8x4 提取码: d8x4